本稿は、ノートPC 向けAI SoC で現在最高性能のAMD 社Ryzen AI Max+ 395 128GB メモリを実装したノートAI PC とミニAI PC をAI 利用開発シーンの観点から比べ、どちらがどの点で優れているかを評価します。5月投稿 AI PC とミニAI PC の続編です。

Ryzen AI Max+ 395 搭載ノートAI PC 利用シーンAMD Ryzen AI Max+ 395搭載HPノートPC:ZBook Ultra G1a 価格比較でも用いたヒューレット・パッカード社ノートAI PC :ZBook Ultra G1a AI 利用シーンは、ZBook Ultra G1aでローカルLLMを試す 2025 年7 月10 日、ITmedia 記事を参考にしました。記事概要とLLM (大規模言語モデル)によるAI 利用部分を抜粋したのが下記です。

【概要】ZBook Ultra G1a 詳細解説。Ryzen AI Max+ 395 と128GB RAM を実装したノートAI PC ハードウェアをフルに活かすLM Studio LLM (LLAMA 2-13B )が、実用パフォーマンスを持つことが判る(ページ4 )。

【所感】128GB RAM のうち96GB をGPU メモリにUEFI で設定し(ページ1 )、その時のAI 性能評価。メモリ割付を自動や変更した場合にローカルLLM 性能が変わるか否か、つまり、LLM 性能におけるUMA (Unified Memory Architecture )メモリ容量の比較が欲しい。

※UMA は、AI SoC のCPU/GPU/NPU が同一RAM へ高速アクセスできる特徴がありLLM 処理に有利と言われる。現在Apple 社M1 、AMD 社Ryzen AI Max+/300 シリーズのAI SoC に採用中。

記事を総括すると、128GB 実装Ryzen AI Max+ 395 搭載ノートAI PC が、AI 利用開発に十分使える点は各種AI ベンチマークから判ります。

また、40TOPS 以上のNPU 要件を満たすMicrosoft Copilot PC 購入検討の方にも参考になる記事です。

ローカルAI エージェントのメリット

A4 サイズのZBook Ultra G1a は、14 型(1920×1200 )モニタ付属で1.57Kg です。付属キーボードや周辺機器接続性も申し分ありませんので、可搬性に優れたオールインワンAI 環境をローカル構築できます。

このノートAI PC へLLM をインストールし、ローカルAI エージェントとします。開発者の様々な課題や相談事を、AI エージェントと協力して解決するのが、AI 利用開発です。

AI エージェントには、Copilot やGemini のクラウド版もありますが、情報漏洩を気にせずカスタマイズ利用できるローカル版ならではのメリットがあります。また、クラウドAI エージェントを上手く活用するためのアドバイスもローカル版から得られるなど、活用方法も多いです。

今後の開発案件は、ローカルAI エージェントを利用し、より高度で生産性の高いAI 利用開発へ進化すると思います。

※LLM とローカルAI エージェントについては、ローカルLLM って何 、2025 年7 月7 日、@IT 記事に判り易い解説があります。

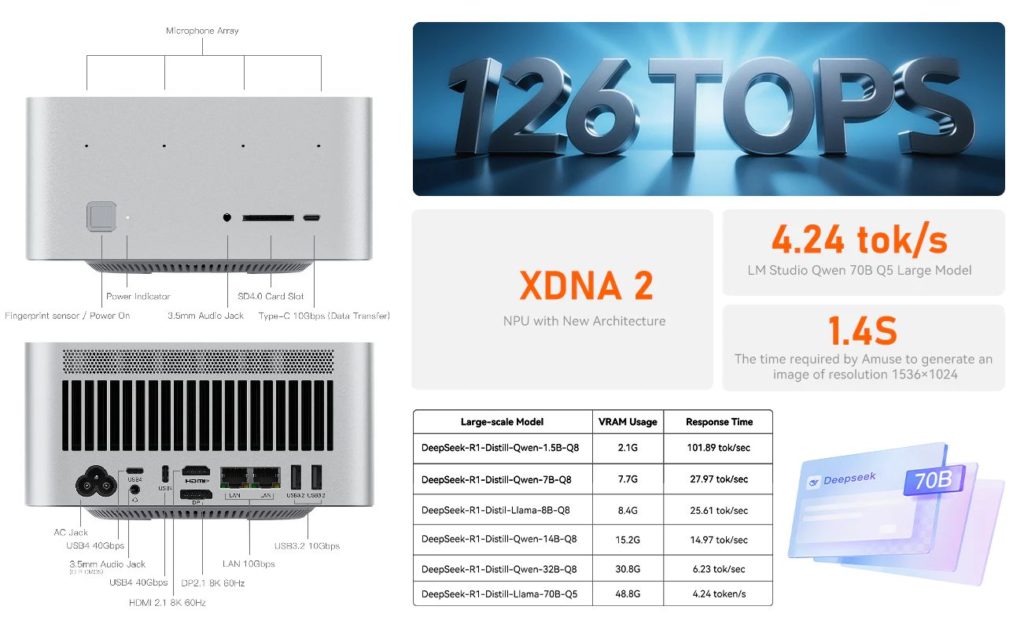

ミニAI PC 開発環境構築

AMD Ryzen AI Max+ 395搭載ミニPC:GMKtec EVO-X2 ノートAI PC と同じAI SoC と128GB RAM 搭載ミニAI PC のGMKtec 社EVO-X2 AI エージェントをAI 開発で利用できる点はITmedia 記事と同じです。但し、ノートPC からモニタとキーボードを外し小型筐体化したミニAI PC は、別途モニタ、キーボード、マウスなどが必要です。そこで、筆者主観でこれら周辺機器を下記の様に選定し、1 章のノートAI PC 開発環境と比較します。

【モニタ】開発用としては27 型(2560×1440 )モニタが、拡大/ 縮小なしの100% 表示で使えるため、優れています。

4K (3840×2160 )などの高精細モニタは、文字が100% 表示では小さく表示されるため、150% 程度の拡大表示が推薦されます。拡大表示は、モニタ単独使用の場合は問題ありませんが、マルチモニタ接続時に利便性が悪化します。例えば、100% 表示ノートPC と150% 表示のマルチモニタ接続時は、ノートPC 側モニタの文字や絵が小さくなるなどです。

また、高精細モニタは、カーソル移動ピッチも大きくする必要があります。マルチモニタ接続時は、モニタ右端からもう片方のモニタ左端へマウスを移動するため、通常ピッチでは小さすぎるからです。

以上から、100% 表示でA4 サイズ紙面2 ~3 枚をほぼ実寸で並列表示できる27 型(2560×1440 )モニタが筆者好みです。

【キーボードとマウス】筆者は、ThinkPad ノートPC を長年使っているため、トラックポイント・キーボード が好みです。また、マウスよりカーソル移動スピードが簡単に可変できるトラックボール を愛用しています。

ローカルLLM 活用AI 開発シーンのノートAI PC とミニAI PC 比較

ノートAI PCとミニAI PCのAI利用開発シーンのイメージ(出展:GMKtec) ノートAI PC とミニAI PC のローカルLLM 活用AI 開発シーンのイメージ図です(PCは異なります)。

ノートAI PC でも外付けモニタ接続で生産性は上がります。しかし、14 型モニタ単独利用の場合は、検討結果の表示には適しても、検討段階の様々な開発パラメタや比較表示には表示面積が小さすぎます。また、外付けモニタ接続時は、前章の拡大表示やカーソル移動ピッチに注意も必要です。

従って、AI 利用の開発シーンでは、様々な検討を行い、その結果が簡単に表示できるミニAI PC 環境が勝ります。ノートAI PC は、移動先で最終結果の顧客表示には適しますが、検討段階ではモニタ追加が必須です。

可搬性重視のノートAI PC は、付属入出力機器にそのしわ寄せが生じます。AI 開発結果プレゼンが主用途です。

一方、ミニAI PC は、様々なAI 活用開発シーンに合わせた機器接続が容易です。効率的なAI 開発検討が主用途です。ミニPC 本体自体は、無理すれば可搬可能です。

Summary :Ryzen AI Max+ 395 ノートAI PC とミニAI PC の開発シーン比較

比較項目 ノートAI PC :ZBook Ultra G1a ミニAI PC :EVO-X2

可搬性 A4 サイズ小型・軽量で可搬性大140W 付属本体は可搬可能230W 付属

出力モニタ 14 型(1920×1200 )単独でA4 一枚表示27 型(2560×1440 )単独で実寸2 枚A4 表示

入力機器 付属キーボードで最低限は可能

好みの入力機器接続容易

開発とは、AI 利用の有無に限らずカット&トライです。最終結果は、様々なトライから開発者が主観評価した結果の1 つにすぎません。他にもっと良い結果が潜んでいる可能性もあります。AI 利用開発は、AI エージェントから新な客観的評価結果が得られるかもしれません。

但しAI 利用開発シーンでは、ハルシネーション対策のためAI 出力の開発者検証プロセスは必須です。従来よりも多角的・多面的な開発視点が必要です。この意味でAI 利用開発に出力モニタは最重要な周辺機器

付属モニタにしわ寄せが生じる可搬性重視ノートAI PC よりも、マルチモニタ出力容易なミニAI PC は、入手価格のみならずこの点でも優れています。

リンク