Ryzen AI MAX+ 395搭載ミニPC(出典:GMKtecメール) 3 月21 日投稿の最新ミニPC 記載Ryzen AI 9 HX 370 のCPU/GPU を強化したRyzen AI Max+ 395搭載のミニPC GMKtec 社よりメール受信しました。今ならメールアドレス登録とアンケート回答で、$30 割引クーポンゲットのチャンスがあります。

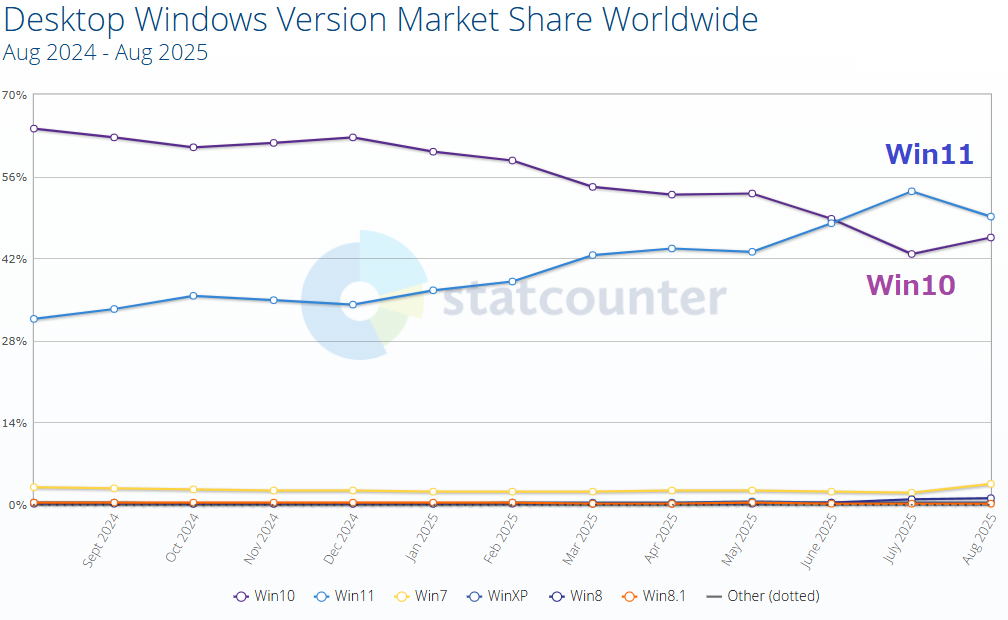

Ryzen AI CPU 性能AMD 社のAI PC 向けCPU 製品名がAPU (Accelerated Processing Unit )です。NPU とGPU をSoC で一体化したCPU のことです。弊社はこのAPU を解り易く「AI CPU Ryzen AI CPU は、AI 300 とAI Max の2 シリーズが発売中です。

3 月21 日投稿のAI CPU は、AI 300 シリーズのRyzen AI 9 HX 370 。発売予告は、より高性能なAI Max シリーズのRyzen AI Max+ 395 です。Ryzen AI CPU 性能は、シリーズ名が異なっても最後の数字370 や395 が性能を表す ので判り易いです。

Ryzen AI Max+ 395 の内蔵NPU は下表のようにRyzen AI 9 HX 370 と同じ50TOPS ですが、CPU と内蔵GPU を強化しています。このAI CPU 搭載ミニPC が、最初の図のGMKtec 社EVO-X2 です。NPU+GPU+CPU のトータルAI 性能は、126TOPS 、70B LLM サポートのミニPC としては世界初です。

Ryzen AI CPU Cores / Boost2 / Base Cache Graphics Model TDP NPU

Ryzen AI Max+ 395

16C/32T Up to 5.1 / 3.0 GHz 80MB Radeon 8060S 45-120W 50

Ryzen AI 9 HX 370

12C/24T Up to 5.1 / 2.0 GHz 24MB Radeon 890M 15-54W 50

Ryzen AI Max+ 395 搭載EVO-X2 Ryzen AI Max とAI 300 の2 シリーズでNPU 性能が同じ理由は、AMD/Intel/Qualcomm 3 社のAI アプリ共通実行環境が無いこと、ビジネスAI キラーアプリが無いことだと思います(NPU懸念投稿 50TOPS のNPU でエッジAI PC に十分かは、前回投稿AI PC NPU役割

これらから、トータル126TOPS を持つEVO-X2 は、PC ゲームよりエッジAI アプリ開発やAI 画像処理向きを狙ったのかもしれません。前述アンケートにも用途欄がありました。

そこで、「70B LLM のAI PC とは、具体的にどのようなPC ですか」とGemini に問い合わせたところ、Afterword添付 の回答を得ました。要するに、ノートPC では困難なローカルエッジAI 単独処理も可能なハイエンドPC で、RAM は最低でも64GB 必要という回答をGemini から得ました。

また、70B LLM 大規模モデル全体をNPU のみで処理するのは困難でCPU とGPU の役割も必要なことが判る(少し古いと思いますが)良い回答です。AI PC 購入検討の方は、参考になると思います。

70B LLM 能力は、クラウドAI を使わずAI PC 単独のエッジAI 処理開発などに必要です。同様に単独でエッジAI 処理を行う最新MCU を次に示します。

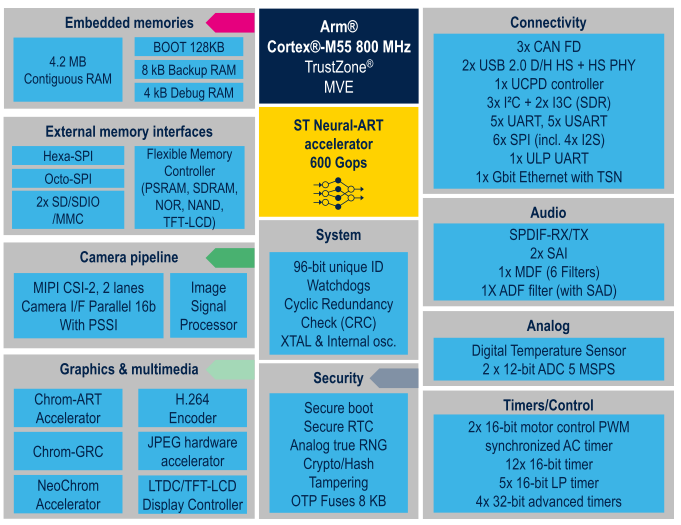

AI MCU :STM32N6 のAI 処理エッジAI 処理は、MCU へも普及し始めています。2025 年発売ST マイクロ社の最新MCU 、STM32N6 Cortex-M55 コア、0.6TOPS NPU 内蔵、4.2MB RAM )は、従来MCU では困難であったAI 処理を、高性能MPU よりも低コスト、低消費電力で実現します。

STM32N6 Black図 STM32N6 のAI 処理例は、カメラ付きSTM32N6570-DK Discovery kit AIデモ動画 4:50 )で判ります。リアルタイムの複数人体認識(0:30 頃)や高速画像処理(0:50 頃)など、STM32N6 内蔵NPU/GPU とCortex-M55 MCU 双方の活用により全く新しいMCU アプリが期待できます。

デモ動画をよく見ると、NPU/GPU 使用時と未使用時の処理差、MCU 負荷差も判りとても興味深いです。

STM32N6 は、MCU 版のAPU 、つまり「AI MCU MCU ベースのエッジAI MCU は、今後急増すると筆者は予想します。AI PC によりユーザがAI に慣れてくると、組込み機器もAI 処理が当たり前になるからです。

※今後AI 処理はユーザにAI 有無を意識させないように進化すると筆者は考えています。

Summary :AI CPU とAI MCU AI CPU Ryzen AI Max+ 395 搭載のトータルAI 性能126TOPS 、70B LLM サポートのミニPC :GMKtec EVO-X2 は、4 月15 日午前0 時 ( 太平洋夏時間) 先行発売開始です。ローカルエッジAI 単独処理可能なハイエンドPC で、AI アプリ開発やAI 画像処理開発に好適です。

AI MCU STM32N6 のAI デモ動画から、エッジAI アプリ開発やAI 画像処理には、AI 処理特化のNPU だけでなくGPU やCPU/MCU も必要です。

Afterword :70B LLM サポートAI PC のGemini 回答70B LLM (700 億パラメータの大規模言語モデル)をサポートするAI PC は、ローカル環境で高度なAI 処理、特に大規模言語モデルの推論や微調整を効率的に実行できるように設計された高性能なパーソナルコンピュータです。具体的には、以下の要素を備えていることが求められます。

主要なハードウェア要件:

高性能GPU: 70B LLM の実行には、膨大な計算リソースとメモリ帯域幅が必要です。そのため、以下のようなハイエンドGPU が推奨されます。

NVIDIA GeForce RTX 3090 、RTX 4090: 24GB 以上のVRAM (ビデオメモリ)を搭載し、高い並列処理能力を持つことが望ましいです。より大規模なモデルや高負荷な処理には、NVIDIA A100 などのプロフェッショナル向けGPU がさらに適している場合があります。AMD Radeon RX 7900 XTX: 高いVRAM 容量と処理能力を持ち、NVIDIA GPU の代替となる可能性がありますが、LLM のエコシステムはNVIDIA CUDA への最適化が進んでいることが多い点に注意が必要です。

高性能CPU: LLM の実行にはGPU が主に使われますが、CPU もデータの前処理、後処理、およびシステム全体の制御において重要な役割を果たします。

Intel Core i7/i9 ( 最新世代): 高いクロック数と多くのコア数を備えたCPU が推奨されます。AMD Ryzen 7/9 ( 最新世代): 同様に、高性能なRyzen プロセッサも適しています。

大容量メモリ(RAM ): LLM のモデル全体または一部をメモリにロードして高速に処理するために、十分なRAM が必要です。

64GB 以上: 70B LLM を効率的に扱うためには、最低でも64GB 、理想的には128GB 以上のRAM が推奨されます。

高速ストレージ(SSD ): LLM のモデルファイル(数十GB から数百GB になることがあります)や関連データを高速に読み書きするために、NVMe SSD が必須です。

1TB 以上: モデルファイル、データセット、作業用ファイルなどを保存するために、十分な容量のSSD が必要です。2TB 以上あるとより安心です。

AI PC としての特徴:

上記のような高性能なハードウェアに加えて、70B LLM をサポートするAI PC は、以下の特徴を持つことが期待されます。

AI 処理に特化したハードウェア: 近年のAI PC は、CPU やGPU に加えて、NPU (Neural Processing Unit )と呼ばれるAI 処理に特化したプロセッサを搭載している場合があります。NPU は、特定のAI タスク(例えば、自然言語処理の一部)をCPU やGPU よりも低消費電力かつ効率的に実行できますが、70B LLM のような大規模モデル全体をNPU だけで処理することは現状では難しいです。ただし、将来的にNPU の性能が向上すれば、より大きな役割を果たす可能性があります。最適化されたソフトウェア: AI PC のハードウェアとソフトウェアが連携し、LLM の実行効率を高めるための最適化が行われている場合があります。これには、ドライバの最適化、特定のAI フレームワークとの互換性向上などが含まれます。

高度な冷却システム: 高性能なCPU やGPU は発熱量が大きいため、安定した動作を維持するために、強力な冷却システム(高性能な空冷ファンや液体冷却システム)が搭載されていることが重要です。

将来性と拡張性: 今後さらに大規模なモデルが登場する可能性や、追加のハードウェア(GPU など)を増設する可能性を考慮して、ある程度の拡張性があると望ましいです。

補足:

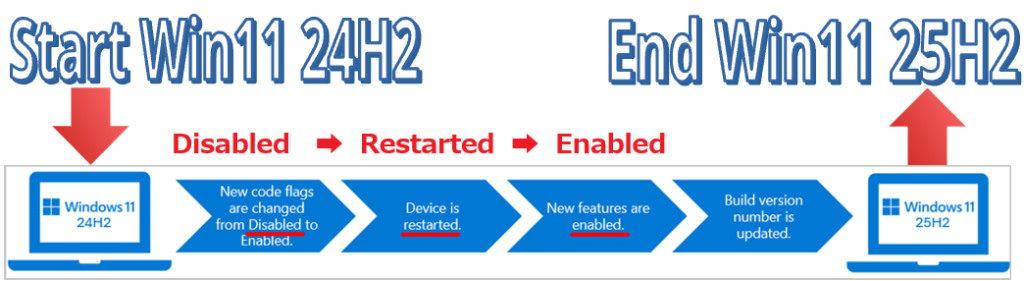

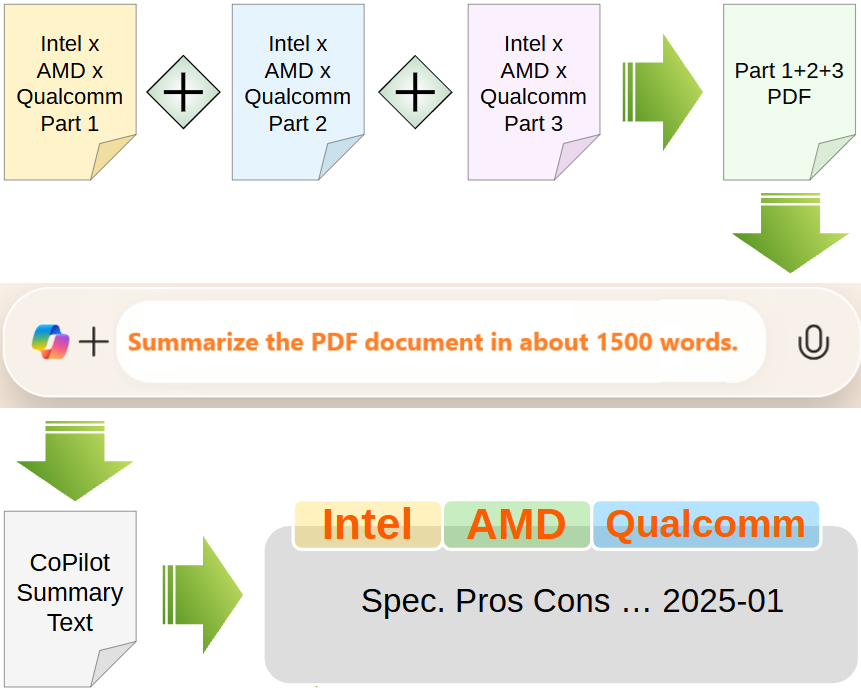

70B LLM をローカルで快適に動作させるためには、上記のハイスペックな構成が必要となり、一般的なノートPC では難しい場合があります。多くの場合、ハイエンドなデスクトップPC が推奨されます。LLM の実行には、モデルの量子化(パラメータの精度を低くしてメモリ使用量や計算量を削減する技術)や、複数のGPU を連携させる技術(Multi-GPU )が用いられることもあります。AI PC の定義は進化しており、Microsoft などが提唱するCopilot+ PC のような新しい基準も登場しています。これらの基準には、一定のAI 処理性能を持つNPU の搭載などが含まれていますが、現時点では70B LLM の実行に特化した要件とは限りません。

まとめると、70B LLM をサポートするAI PC は、非常に高性能なGPU (24GB 以上のVRAM )、高性能CPU 、大容量メモリ(64GB 以上)、高速SSD (1TB 以上)、そして高度な冷却システムを備えた、主にハイエンドなデスクトップPC NPU を搭載したPC が登場することで、より効率的なLLM のローカル実行が可能になるかもしれません。