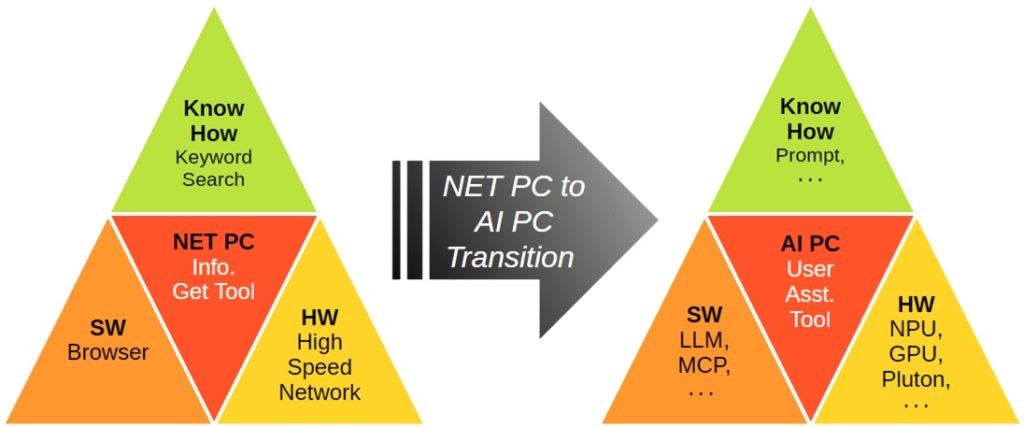

エッジAI処理最適化NPU必要性、ローカルLLMとは、PCユーザ対処とは 4 月25 日、Win11 24H2 向け5 月「先行」更新プログラム:KB5055627 Recall など多くのAI PC機能がWin11 24H2へ追加 Rufus 4.7 で手動アップグレードした弊社Win11 24H2 NPU が無いためこれら新しいエッジAI PC 機能は使えません😢。

なぜNPU が無いとAI 機能が使えないのか、大規模言語モデル:LLM とは何か、急成長するAI へPC ユーザはどう対処すべきか、を考察しました。

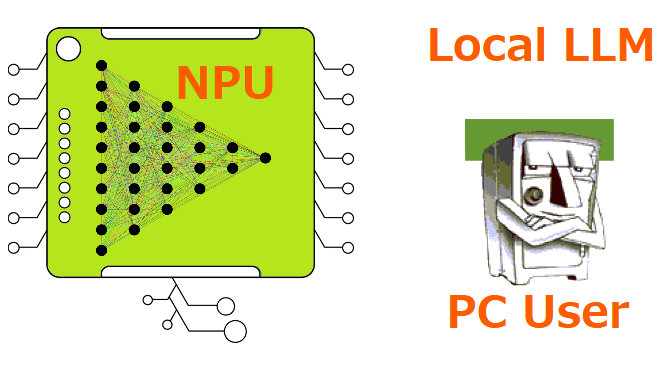

AI PC 最重要ハードウェア:NPU (Neural Processing Unit )AI PC と従来PC の差は、NPU ハードウェアを持つか否かです。エッジAI 最適設計のNPU は、高速並列処理で低消費電力なAI 専用プロセサです。

筆者は、従来PC の高性能CPU/GPU でも無理やりエッジAI 処理を行うことはできると思います。しかし、次章に示すLLM やAI アプリの処理速度、電力消費の点でAI 専用NPU が優れ、その結果、AI アプリ実行要件にNPU ハードウェアを指定したと思います(PC 買換え喚起の狙いもあると思いますが…)。

NPU を持つAI PC は、今後のPC 使い方を大きく変えます。AI 活用でPC がより使い易く、高い生産性になるからです。AIスマホ AI PC を使うと従来PC へは戻れないでしょう。

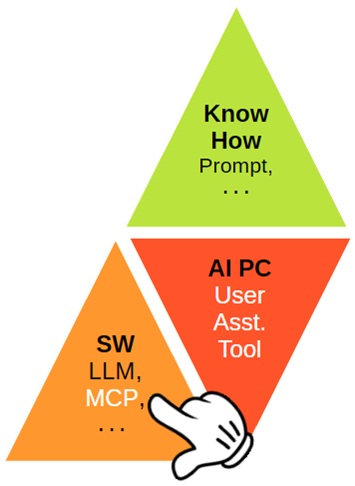

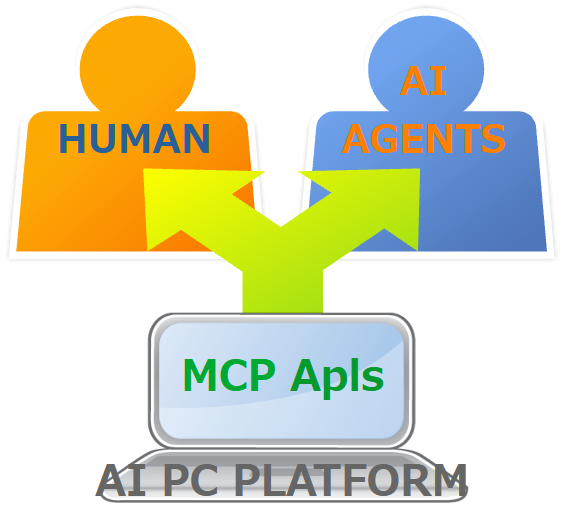

LLM (大規模言語モデル)ローカルLLMは、プライバシー保護に優れたエッジAI PCとユーザ間インタフェースの役目 LLM :Large Language Model は、大量テキストデータの学習結果から、ユーザに判り易い文章を生成するAI です。

このLLM は、既にクラウドAI の入出力インタフェースとして稼働中です。例えば、ブラウザのAI 対話アシスタント:Gemini/Copilot へ、ユーザが入力した質問テキストを解析し、ユーザ自然言語で回答を出力するのもこのLLM がクラウドAI のフロントエンドにいるからです。

このLLM をエッジAI PC のNPU で動作させるのが、ローカルLLM です。オフラインでもLLM が動作しますので、AI アシスタントやビジネスデータのAI 分析・解析などをPC 上で行っても、クラウドへの情報漏洩は防げます。

つまり、ローカルLLM は、プライバシー保護に優れたエッジAI PC とユーザ間インタフェースの役目を果たします。

最初に示したRecall などのAI 機能操作は、殆どが未だ従来のGUI ベースです。これは、自然言語対応済みのAI スマホに比べ、AI PC ユーザインタフェースが遅れていることを示しています。

Win11 24H2 は、従来PC とAI PC 両方動作(=中途半端) ですので、この遅れもやむを得ません。しかし、次期AI PC 専用Win12 では、GUI から自然言語対応PC へと改善されるでしょう。

ローカルLLM 実装例

4 月25 日、AI PC のNPU へローカルLLM をインストールするとどう変わるか、RAM 使用量による日本語対応などが判る記事 がインプレスに掲載されました。ごく簡単に要約すると、

ローカルLLM :AnythingLLM AI PC へインストールすると、日本語テキストでAI PC 情報を入出力できる。

使用RAM 4GB と6.5GB で比較すると、使用量が多いほど正確な日本語対話になる。

上記のLLM は、3B/8B で、関連投稿で示したAI アプリ開発用ミニPC の70B LLM 700 億パラメータの大規模言語モデル)に比べると小規模です。一般ユーザのAI PC なら、記事3B/8B 程度のLLM でも役立ちそうです。

上記投稿Afterword に示したようにLLM を効果的に使うには、高速大容量RAM がBetter です。AI PC 専用Win12 は、できだけ大容量のDDR5 RAM を実装したいです。

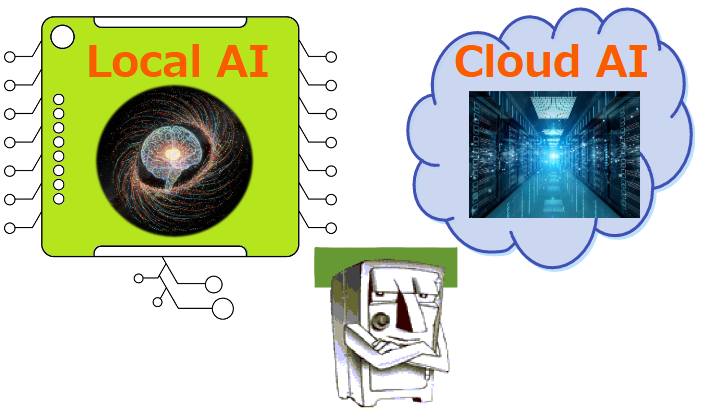

AI PC へローカルLLM をインストールすると、クラウド情報漏れを気にせず、GUI に代わる自然言語でAI 機能やPC サポートが得られます。但し、クラウドAI に比べるとローカルAI は当然非力ですから、ユーザはこの点を考慮・工夫して利用すべきです。

AI PC のNPU 能力に適したエッジAI アプリは、今後増えます(一例が次章)。ローカルとクラウド両方のAI を、必要に応じて使い分けるPC 環境が整いつつあります。

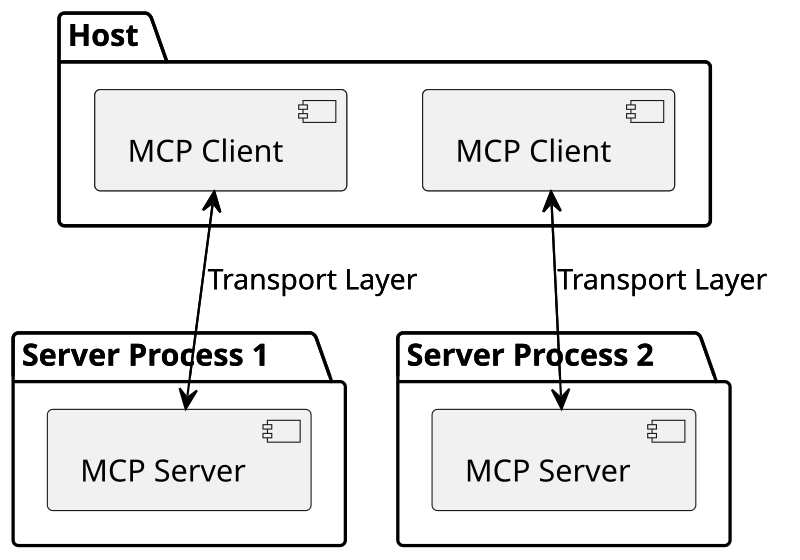

Windows 自動化AI エージェント:computer use 4 月15 日、Microsoft は、Windows 操作を自動化するAI エージェント「computer use 」を発表とキーマンズネット記事 が掲載しました。

従来のWin 自動化ツールとの違いは、対象アプリや利用サイトに変更が生じた場合でも、エッジAI 推論により変更に自動対応できることです。市場調査とその洞察、請求書処理などをこのAI エージェント任せにできるそうです。5 月19日開催Microsoft Build

AI エージェントに任せた出力結果は、ユーザによる最終確認が必須です。しかし、自動化AI エージェントでPC 生産性は上がります。AI PC 普及に合わせ、このようなエッジAI 活用アプリは急増します。

Summary :NPU とローカルLLM ローカルAIとクラウドAIを使い分ける能力がPCユーザに必要 AI 処理専用ハードウェア:NPU は、AI アプリ高速処理と低消費電力の両方を満たすためエッジAI PC に必須です。NPU 活用のAI は、従来PC の使い方を大きく変え、より使い易く、より高い生産性をユーザへもたらします。

例えば、クラウドAI 稼働中のLLM をエッジAI PC へインストールすると、プライバシー保護に優れるローカルLLM を構築でき、従来GUI に代わる自然言語でAI PC が簡単に使えるようになります。

エッジのローカルAI とクラウドAI の利用環境が整ってきました。ユーザは、ローカル/ クラウドAI を使い分ける能力も必要になります。

Afterword :筆者希望AI エージェントアプリ

Chrome/Edge/Firefox自動 更新

複数メールアカウント巡回と迷惑メール自動削除

MCU/AI PCなど関心トピックの自動収集・分析

上記AI エージェント(アシスタント)処理を希望します。これでPC 作業効率や生産性は確実に上がります。全ユーザ要求に対応するクラウドAI 汎用性は、エッジAI PC には不要です。これらAI エージェントアプリだけなら、小規模LLM 、少ないRAM のAI PC でも処理できるハズです。AI アプリを自作すれば、なお良いのですがね…😓。